Un siècle de dualisme

L’idée que les êtres vivants, par la vie qui les anime, auraient une particularité en eux-mêmes au delà de ce qui est strictement mesuré, est considéré par Claude Bernard comme une cause première qui n’a pas sa place dans la science. Positiviste, il considère que c’est aller dans le sens d’une meilleure connaissance scientifique que de se détourner des apparences qui nous font voir les êtres vivants comme gouvernés par une autre dynamique que la matière inanimée.

Pourtant ce problème va partager les opinions en deux camps pendant au moins un siècle :

Les plantes et les animaux sont composés souvent de molécules dissymétriques (stéréochimie) que l’on ne rencontre pas naturellement dans le monde minéral. Ces molécules semblent avoir des probabilités très faibles d’apparition d’où un conflit apparent avec le second principe de la thermodynamique.

La formule de Boltzmann qui interprète l’entropie grâce aux molécules est de 1875. L’hypothèse atomique qui permet de reconstruire toute la thermodynamique (W. Gibbs) sera corroborée par les mesures du nombre d’Avogadro (J. Perrin). Enfin l’indéterminisme quantique vient compliquer le débat (Bohr, de Broglie, Heisenberg, Dirac, Fermi etc.).

La dualité vivant-inorganique s’accuse d’autant plus que les connaissances sur le vivant se perfectionnent et que celles sur le monde physique également.

Le problème du vivant va rester une question épistémologique quant à la frontière entre physique et biologie. Les philosophes prennent parti dont les plus connus sont : Henri Bergson (L’évolution créatrice 1907), Pierre Teilhard de Chardin (Le phénomène humain 1955).

Dans toute la période de 1875 (formule de Boltzmann) à 1975 (et après) un questionnement pressant sollicite la recherche autour de la question de savoir si la mécanique statistique, la physique quantique, etc. éclairent cette zone de litige entre physique et biologie. Toutes appartenances confondues, les auteurs religieux prennent parti pour une spécificité du vivant. Certains savants eux-mêmes, comme Charles Eugène Guye, considèrent que l’attitude positiviste est trop restrictive. Nous sommes encore très fortement marqués par cette pensée dualiste qui a été le cadre accepté à l’époque de nos parents ou grands parents.

Ce dualisme opposant durant près d’un siècle les scientifiques positivistes et les personnalités plus spiritualistes, vint à être reformulée dans les années 1970. A la suite des travaux de Lars Onsager, de nombreux chercheurs dont Ilya Prigogine, ont montré que la simple constitution de système ouvert rendait à l’être vivant des potentialités en toute conformité avec les lois physiques, montrant ainsi que l’homme était intrinsèquement dans la fragilité ontologique de la dépendance de flux qui le maintiennent en vie.

Léon Brillouin

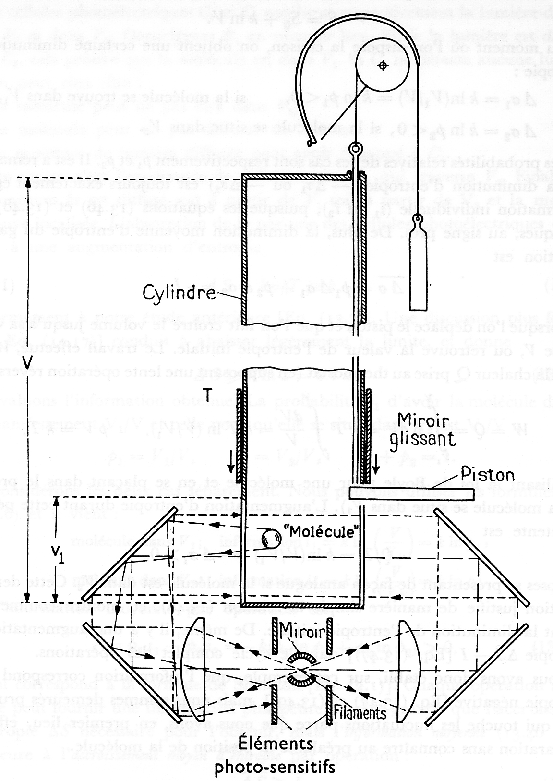

Le physicien Léon Brillouin a développé l’idée que l’entropie et l’information étaient des grandeurs opposées, signalant que ceci avait été envisagé déjà par plusieurs auteurs dont L. Szilard (Z. Physik, 53, 840 (1929)), Dennis Gabor et Norbert Wiener. L’information dont il s’agit est probabiliste, elle s’apparente à la formule de Boltzmann ou à celles de Shannon, elle qualifie combien rare est la situation présente au sein d’un ensemble de situations similaires probabilisées.  Le lien avec l’entropie est déduit d’expériences idéales décrites dans le chapitre 13 de son ouvrage Science and Information Theory 1956 (trad. française Masson 1959) fondées sur l’impossibilité du moteur perpétuel et les « yeux » du démon de Maxwell. Brillouin insiste sur le fait que les êtres vivants ne sont pas des systèmes fermés et que donc le principe d’accroissement d’entropie ne peut leur être appliqué (Vie, matière et observation Albin Michel 1959), il souscrit à la thèse de Schrödinger du « cristal » expliquant la reproduction des êtres vivants, en perfectionnant cette idée par le fait que les êtres vivants sont capables de fabriquer de l’information c’est-à-dire de trier, de séparer, d’utiliser des catalyseurs, donc de lutter contre le mélange, le broyage généralisé qui fait augmenter l’entropie.

Le lien avec l’entropie est déduit d’expériences idéales décrites dans le chapitre 13 de son ouvrage Science and Information Theory 1956 (trad. française Masson 1959) fondées sur l’impossibilité du moteur perpétuel et les « yeux » du démon de Maxwell. Brillouin insiste sur le fait que les êtres vivants ne sont pas des systèmes fermés et que donc le principe d’accroissement d’entropie ne peut leur être appliqué (Vie, matière et observation Albin Michel 1959), il souscrit à la thèse de Schrödinger du « cristal » expliquant la reproduction des êtres vivants, en perfectionnant cette idée par le fait que les êtres vivants sont capables de fabriquer de l’information c’est-à-dire de trier, de séparer, d’utiliser des catalyseurs, donc de lutter contre le mélange, le broyage généralisé qui fait augmenter l’entropie.

Information

Entropie et information sont des quantifications, des index qui font des bilans. Il y a plusieurs sortes d’information. L’information statistique relative à la précision d’une estimation, avec elle-même plusieurs variantes : de Fisher, de Kullback. L’information probabiliste qui concerne la transmission de messages probabilisés par un canal (Shannon). L’information néguentropique en thermodynamique (Brillouin). L’information algorithmique de Kolmogorov qui décrit la complexité d’une séquence, etc. Pour englober sous un seul concept toutes ces modalités nous devons dire que l’information est un mannequin de la connaissance qui la rend quantifiable. Aussi bien nous pouvons comprendre que la néguentropie est un instrument bien pauvre pour rendre compte du vivant.

Une erreur de Georgescu-Roegen

L’ouvrage The Entropy Law and the Economic Process de Nicholas Georgescu-Roegen est paru en 1971 peu avant le premier rapport du Club de Rome et avant les synthèses des travaux de Prigogine. Son ton, très vindicatif, est sympathique aux yeux des écologistes parce qu’il critique vivement l’économie libérale comme pseudo-science. Aussi est-il abondamment cité et classé parmi les contributeurs de la « transition écologique ».

Au demeurant sa thèse principale est une erreur et les écologistes feraient mieux de ne pas fonder uniquement leurs critères de valeur sur le caractère contestataire ou non du propos. Il écrit « The economic process consists of a continuous and irrevocable transformation of low into high entropy » (p292 et p281).

Il est absolument sans fondement de penser que parmi les activités humaines, l’économie serait responsable d’un accroissement d’entropie. Il y a deux confusions derrière cette idée. D’abord que l’activité de « mélange » qui se produit à cause des déchets et de la pollution a pour seule cause l’économie. Puis que le système Terre voit son entropie augmenter ce qui serait le pire des dangers. Georgescu-Roegen n’a pas clairement réalisé que la biogée est un système ouvert qui reçoit le flux solaire, et que, par exemple, les bactéries et autres organismes ont été capables au cours des millénaires de trier et de concentrer les métaux que nous trouvons dans les minerais aujourd’hui.

L’accroissement d’entropie n’est pas « irrevocable » il n’y a là aucune contrainte théorique. Le problème est purement concret, opérationnel, et lié aux vitesses. Nous mélangeons les métaux en faisant des alliages, nous mélangeons nos déchets plastiques, vitreux, métalliques, et nous ne disposons pas de processus biologiques pour les trier. Sauf quelques cas particuliers d’épuration biologique. Mais on peut penser qu’à très long terme nous aurons remplacé nos décharges par des systèmes biologiques qui sépareront les éléments de nos déchets déjà soigneusement triés.

Le capitalisme est assez destructeur de l’environnement pour qu’on n’ait pas besoin de lui faire de faux procès.

Onto et phylogénèse

La notion d’information est donc pauvre pour qualifier le développement de l’être vivant à partir du « cristal » de Schrödinger c’est-à-dire de la double hélice de Watson et Crick (1954). Ces biologistes sont à l’origine de la présentation des séquences des quatre bases adénine, thymine, guanine, cytosine, avec le vocabulaire de l’information. Ceci fut reçu par les médias comme si toute la biologie pouvait se réduire à la chimie, bouleversement historique en faveur du positivisme. Ce rêve réductionniste est encore largement présent aujourd’hui. Cependant la croyance au réductionnisme absolu, favorisée par la compétition matérialiste des deux blocs, ne résista qu’une vingtaine d’années. La structure de l’ADN est loin de tout expliquer et la question de la synthèse des protéines et des acides aminés s’avère un processus fort difficile à comprendre et à reproduire en raison notamment des phénomènes auto-structurants rencontrés dans les systèmes ouverts.

L’erreur principale de ce réductionnisme est dans la phrase, répétée à l’envi, dans les encyclopédies que toute l’information utile à la construction de l’être vivant est « contenue » dans son ADN. Ceci ne pourrait être vrai que « conditionnellement sachant le contexte à tous les stades du développement ». Or le contexte réel, dans la nature, est impossible à décrire, depuis l’œuf, l’embryon, l’enfant, l’individu dans le social ou l’écosystème.

Le contexte est dû à l’espèce et à son évolution phylogénétique. Donc il y a une double mémoire : germinale et contextuelle.

On voit que le passé joue un rôle primordial, et le passé des êtres vivants est — faut-il le rappeler — un passé naturel. Deux remarques sont à faire à ce sujet.

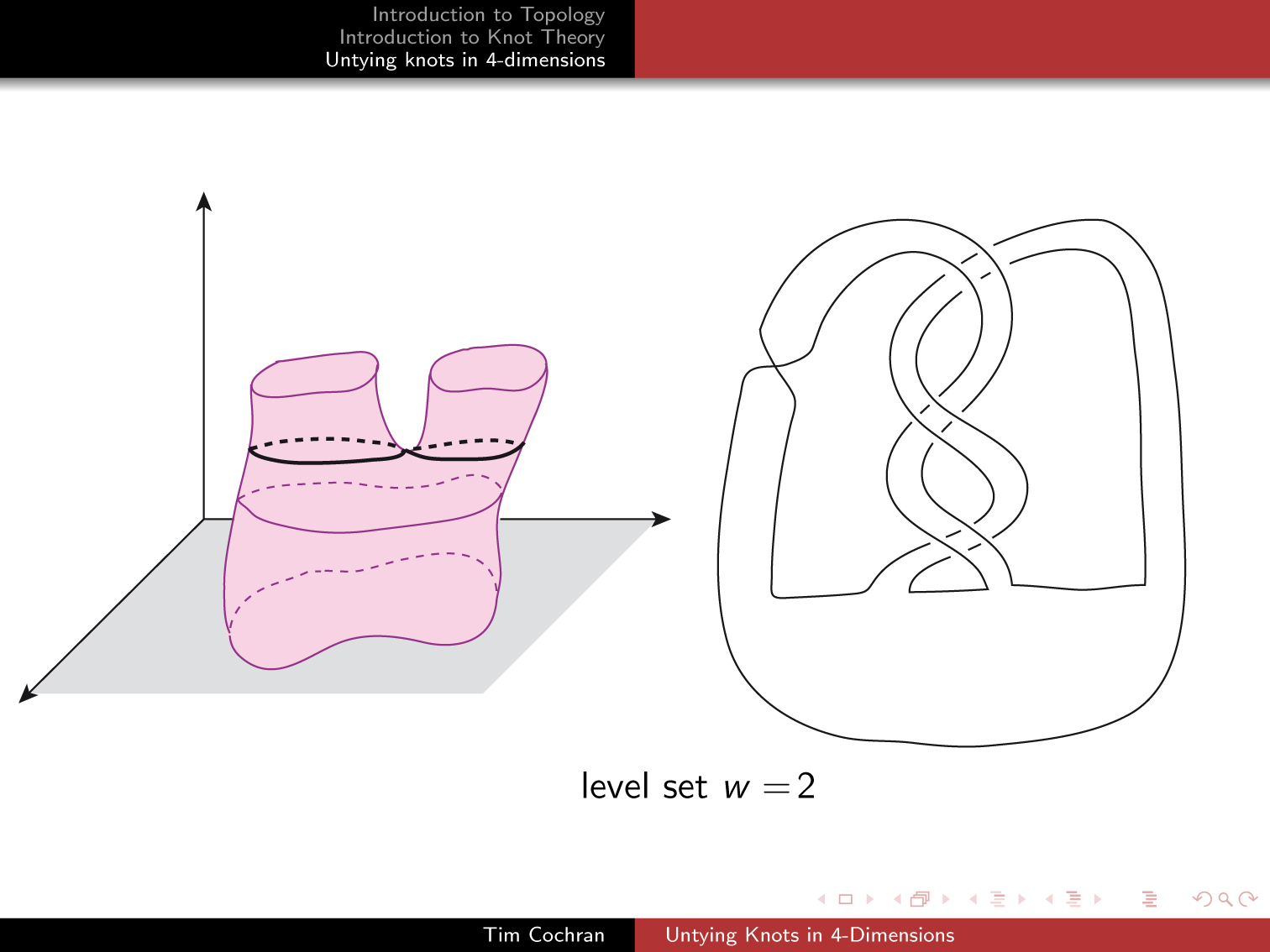

La première est que le hasard lorsqu’il intervient dans l’évolution d’un système n’est pas forcément un « mélangeur », c’est-à-dire un contributeur à l’effet d’accroissement entropique. Un exemple simple est de considérer une promenade aléatoire discrète dans l’espace de dimension 3. On peut montrer que la trajectoire fait des nœuds qui ne se défont pas lorsqu’elle se prolonge[1]. Le hasard fait des nouages.

Il s’agit juste d’un exemple qu’il faut prendre en un sens général : en passant de R3 à des modélisations à grand nombre de paramètres, et passant des modélisations dans Rn à des représentations plus qualitatives ou morphogénétiques[2]. Au cours du développement des structures apparaissent (ni purement déterminées ni purement aléatoires) qui donne une valeur intrinsèque à l’histoire personnelle du point de vue de l’humanisme.

Aussi bien les êtres vivants dans leurs changements ontogénétique et phylogénétique engendrent de la complexité — ce qui fut souvent noté, par Jean Rostand aussi bien que par Teilhard de Chardin — mais chaque modification est fortement contrainte par la situation atteinte par l’évolution passée.

La seconde remarque prolonge celle-ci. L’aventure de la biologie de synthèse est fondée sur l’hypothèse implicite d’une résilience de la biosphère au delà de ce que la nature expérimente aujourd’hui dans le contexte qu’elle a engendré. Les êtres vivants sont susceptibles de voir apparaître des mutations dans leurs patrimoines génétiques, mais ils vivent dans des écosystèmes et chaque mutation n’y est pas soumise uniquement à des exigences individuelles.

Le problème est révélé par les ordres de grandeurs : au cours de l’évolution la nature a expérimenté beaucoup plus que tout ce qui a joué un rôle actif à chaque date pour la reproduction et pour la suite, et ce faisant elle n’a essayé qu’une infime partie des possibles.

Le point est délicat et là nous devons compter. On évalue à 1080 le nombre d’atomes de l’univers observable avec les moyens actuels. Or, comme l’ADN du premier chromosome humain comprend 220 millions de paires, le nombre de variantes d’un ADN de cette longueur est de 4220000000 (il y a 4 bases fondamentales) soit environ 10133000000.

Le résultat est que ce qui est essayé par la nature dans le contexte naturel d’aujourd’hui est une toute petite partie de ce qui est possible. On doit considérer ce contexte comme une zone « protégée » par la myriade des expériences — échecs ou réussites — passées, et par conséquent la modification artificielle de la combinatoire biologique est fondée fondamentalement sur l’idée que la combinatoire est bienveillante au delà de ce qui est le contexte dans lequel nous nous trouvons. Or cela est fondé sur un principe d’induction abusif puisque la seule loi qui s’est appliquée jusqu’ici est celle d’un contexte naturel.

Ces ordres de grandeur plaident en faveur du fait que l’étonnante particularité de l’homme soulignée par Jacques Monod, ne soit qu’un aspect d’une étonnante particularité du vivant dans sa situation actuelle. Plus précisément il se peut que les choix primaires apparus aient mis les axiomes (les cristaux de Schrödinger) dans une configuration telle que certaines molécules très dangereuses ne puissent pas être atteintes par les mutations naturelles mais que les productions artificielles de laboratoire les rende accessibles facilement dans son interaction avec l’existant. Ceci explique la différence fondamentale de nature entre les croisements d’espèces par voie sexuée tels qu’ils furent pratiqués depuis longtemps pour l’agriculture et l’élevage et la biologie de synthèse.

Aujourd’hui les associations qui œuvrent contre les OGM portent principalement le débat sur la question des brevets du vivant, du type d’agriculture et d’élevage que les espèces modifiées entraînent et propagent, ainsi que sur les conséquences des produits phytosanitaires sur la biodiversité. C’est de toute première importance. Mais nous voyons qu’il existe un risque plus grave encore dans la dissémination de nouvelles molécules dans la nature qui est dû à la réactivité du contexte.

Nouages en grande dimension

Nous avons évoqué la fabrication de nœuds dans R3. C’était une image. Mais elle amène immédiatement à se poser la question des nœuds en plus grande dimension, et là, les mathématiciens nous disent qu’il n’y a pas de nœuds en dimension 4 et au delà. Il faut élucider ce point. C’est qu’ils ont une définition très particulière des nœuds et de leurs déformations.

Pour que notre image puisse être retenue en toute dimension il suffit de dire qu’un nouage est une courbe dans Rn qui part de l’origine et va à l’infini telle que l’une au moins de ses projections tridimensionnelle fait des nœuds.

Mais, en passant, nous rencontrons cette question fascinante de comprendre pourquoi il n’y a pas de nœuds dans R4 au sens des mathématiciens. C’est difficile à comprendre. Si difficile que je n’en connais qu’une seule vulgarisation qui éclaire « d’un certain jour » la question.

Dire qu’en dimension 1 on ne peut éviter un point, qu’en dimension 2 on peut éviter un point mais pas une droite, qu’en dimension 3 on peut éviter une droite mais pas un plan, qu’en dimension 4 on peut éviter un plan… n’apporte pas grand chose.

Je renvoie donc à la belle conférence de Tim Cochran « Untying Knots in 4-dimension » (http://math.rice.edu/~cochran/ResearchLectures/Deans_Lecture.pdf) où celui-ci nous montre que des transformations qui nous semblent des brisures et recollements dans R3 peuvent provenir d’opérations continues dans R4.

L’idée est un peu similaire à celle de catastrophe de René Thom. L’œuvre philosophique de Thom a largement illustré que les mathématiques proposaient des outils de représentation qui allaient au-delà du quantitatif grâce à un langage adapté à l’évolution des formes[3]. Cette sémantique tire son origine de la théorie des singularités des variétés différentiables et accorde un rôle typique à la notion de « déploiement universel » comme interprétation explicative. Schématiquement cela consiste à lire l’évolution singulière d’un phénomène comme la projection d’une évolution régulière se situant dans un espace plus grand.[4]

Hyperprion

L’idée simple que la description des êtres vivants nécessite des espaces de grande dimension, éclaire d’un nouveau jour le notion de prion en tant que forme transmissible. Cf. sur ce blog l’article « Les maladies à prions et le concept de prion » de M. Ermonval et F. Jacquemart. Dans certaines circonstances il se pourrait que des structures relatives à d’autres paramètres que la localisation dans l’espace tridimensionnel puissent se transmettre. Ceci pourrait-il rendre compte de certains aspects de l’embryogenèse ou de la transmission de pathologies ?

[1] Pippenger N. ”Knots in random walks”, Discrete Applied Math. 25 (1989) 273-278.

[2] Calude C. S. and Longo G. « Classical, Quantum and Biological Randomness as Relative Unpredictability » CDMTCS-474, October 2015.

[3] R. Thom, Stabilité structurelle et morphogenèse, Benjamin, 1972.

[4] Citons parmi les termes de base : la queue d’aronde, le papillon, les ombilics, le pli, la fronce, la chréode, etc. Le traité de J. Petitot-Cocorda Physique du sens, éd. CNRS, 1992, est un approfondissement dans ce sillage.